La NASA y las manipulaciones del color de las fotos de Marte

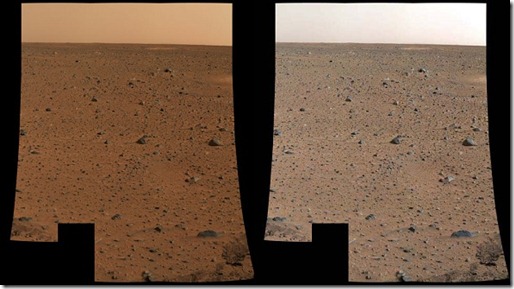

El 6 de enero de 2004 la NASA publicó la primera imagen tomada por el primer rover que aterrizó en Marte, el Spirit. La imagen mostraba un terreno y un cielo muy rojizos, por lo que algunos pensaron que había sido manipulada. Hubo quien editó la imagen para disminuir el nivel de rojo y ver el resultado. Quedó algo como lo que veis a continuación. La imagen de la izquierda es la original de la NASA, y la de la derecha es la manipulada. Muestra unos tonos más naturales, y… un cielo azul.

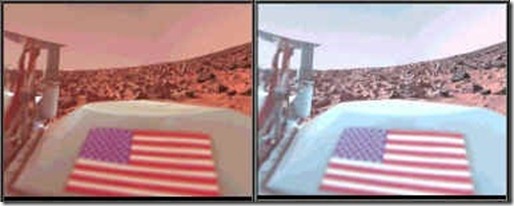

Es posible que el suelo de Marte sea menos rojizo de lo que aparece en la toma de la NASA. Por otro lado, el que exista un cielo azul no es incompatible con que Marte siga siendo el planeta rojo visto desde el espacio. Las dudas ya venían de tiempo atrás, ya que la sonda Viking envió una imagen en la que se apreciaba la bandera de los Estados Unidos muy desplazada hacia el rojo. Al fondo de la imagen también se apreciaba el suelo y el cielo marciano. Aquí ya había colores de referencia con los que comparar. Al desplazar el color para que la bandera se mostrase natural, también quedaba un cielo azul.

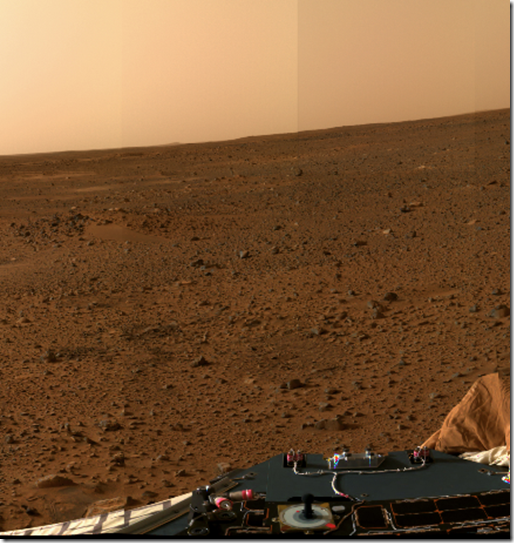

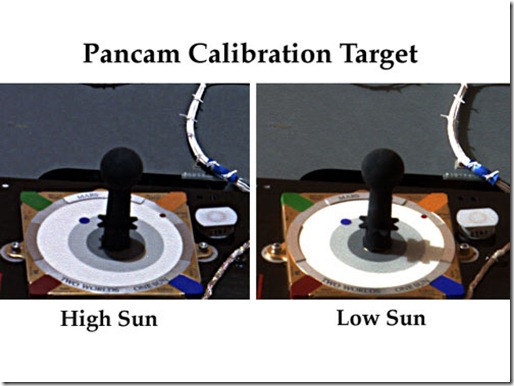

Hay otro hecho más inquietante aun. Esta es una de las primeras fotos enviadas por el rover, todavía sobre la cápsula abierta con la que aterrizó. Si miramos la imagen siguiente vemos un paisaje marciano, y en la parte inferior un extraño dispositivo que parece un joystick, y que realmente es un sundial, una herramienta para ayudar en la calibración del color en las tomas de la NASA, y por medio de la sombra proyectada conocer la hora marciana y la época del año.

Podéis acceder a la imagen al alta resolución aquí.

Notad los colores del sundial y comparadlos con los originales.

El color azul se ha convertido en rojo intenso.

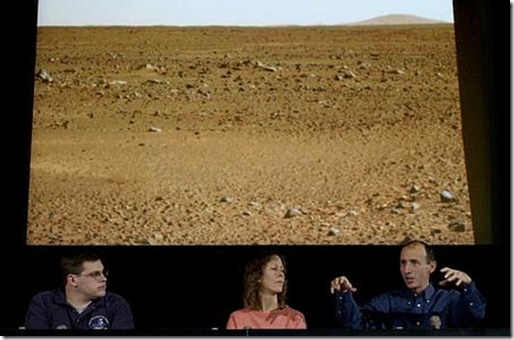

El 10 de enero de 2004 la NASA dio una rueda de prensa, y mirad una de las imágenes que proyectó en la pantalla ubicada detrás de los conferenciantes. De nuevo un cielo azul.

Los conspiranoicos inmediatamente sospecharon que esta imagen se les escapó a la NASA, que deliberadamente está tratando de ocultarnos que las condiciones de Marte no son tan diferentes a las de la Tierra, e incluso, ¿por qué no?, podría ser habitable.

Pero, conozcamos un poco más en profundidad los detalles del instrumental de los rover y de las cámaras que llevan montadas para entender mejor esta cuestión.

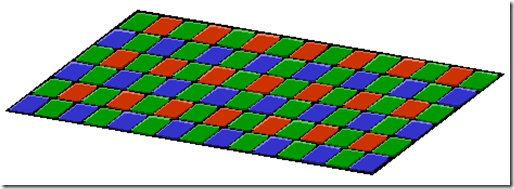

En primer lugar es necesario saber las nociones básicas del funcionamiento de las cámaras digitales. El corazón de una cámara digital es el CCD (charge coupled device) o sensor que capta la intensidad luminosa que llega a cada célula de su rejilla y que dependiendo de la intensidad excita en mayor o menor medida dichas células produciendo un pixel que tendrá un valor más o menos alto. Las células del CCD no tienen la capacidad de distinguir los colores, solo la intensidad luminosa, por lo que solo pueden tomar fotografías en un color ( imaginemos que en ByN). Las cámaras como las que tenemos en casa, resuelven el problema de los colores por medio de una máscara de bayer por medio de la cual cada pixel de la fotografía es el resultado de componer el resultado de 4 pixels (uno azul, uno rojo y dos verdes).

El problema de este mecanismo es que los pixels se espacian demasiado, por lo que las cámaras comerciales tienen que incluir un mecanismo de interpolado. En el rover, no se puede permitir el lujo de perderse un detalle, por lo que este sistema no vale.

Un mecanismo para evitar esta pérdida es utilizar filtros. Uno para el azul, uno para el rojo, y otro para el verde (RGB) y después componer la imagen superponiendo las tres tomas.

Es importante tener presente que ninguna cámara digital toma fotos en True Color. Todas son composiciones. No hay ninguna cámara que pueda tomar fotos exactamente como las percibe el ojo humano.

El ojo humano tiene tres tipos de conos que son las células de la retina que tienen la capacidad de percibir el color. Hay conos con capacidad de percibir el rojo, otros el verde y otros el azul. En el siguiente diagrama se pueden apreciar las diferentes longitudes de onda de la luz visible que excitan a cada uno de estos tres tipos de conos. Los conos azules se excitan con ondas de longitud 445 nm., los verdes con ondas de 535 nm. y los rojos con ondas de longitud 570 nm.

Comprobando las especificaciones de la cámara panorámica de los rover, comprobamos que en cada una de las lentes hay 8 filtros.

| Cámara Izquierda | Cámara Derecha |

| L1. EMPTY | R1. 430 (SP) * |

| L2. 750 (20) | R2. 750 (20) |

| L3. 670 (20) | R3. 800 (20) |

| L4. 600 (20) | R4. 860 (25) |

| L5. 530 (20) | R5. 900 (25) |

| L6. 480 (25) | R6. 930 (30) |

| L7. 430 (SP)* | R7. 980 (LP)* |

| L8. 440 Solar ND | R8. 880 Solar ND |

(SP= short-pass, LP=long-pass)

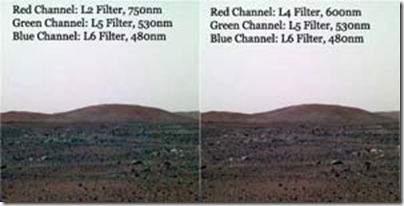

Los valores típicos para una toma RGB son 600 nm para el rojo, 530 para el verde y 480 para el azul, que coinciden con los filtros L4, L5 y L6. Pero en la mayoría de las imágenes que toman los rover, el filtro L4 es sustituido por el filtro L2, que está en el límite de la franja infrarroja, con la finalidad de conseguir tomas con más detalles y mayor percepción en la zona de sombras. Utilizando el filtro L2, los colores azules son especialmente brillantes. Esta es la razón por la que vemos esa distorsión.

Para comprobar que esto es cierto, tomemos dos juegos de imágenes tomadas del repositorio de la NASA. En este primer juego podemos ver el sundial fotografiado utilizando los filtros L4, L5 y L6. La codificación de la fotografía ayuda a identificar el filtro que se usó.

http://marsrovers.jpl.nasa.gov/gallery/all/2/p/003/2P126632830ESF0200P2899L4M1.JPG

http://marsrovers.jpl.nasa.gov/gallery/all/2/p/003/2P126632883ESF0200P2899L5M1.JPG

http://marsrovers.jpl.nasa.gov/gallery/all/2/p/003/2P126632935ESF0200P2899L6M1.JPG

Este segundo juego sustituye el filtro L4 por el L2.

http://marsrovers.jpl.nasa.gov/gallery/all/2/p/004/2P126725406ESF0200P2095L2M1.JPG

http://marsrovers.jpl.nasa.gov/gallery/all/2/p/004/2P126725437ESF0200P2095L5M1.JPG

http://marsrovers.jpl.nasa.gov/gallery/all/2/p/004/2P126725479ESF0200P2095L6M1.JPG

Si con la ayuda del photoshop desplazamos cada una de estas fotografías al color correspondiente y las solapamos en tres capas superpuestas, las imágenes que obtendríamos serían estas:

Serie 1:

Serie 2:

Pero esto no es todo. Cada una de las tomas realizadas por las cámaras del rover son normalizadas digitalmente por un procesador que lleva incorporado el sistema que controla la exposición. Esto quiere decir que la conversión analógica digital no es siempre la misma sino que varía dependiendo de la señal que le llegue tomando como 0 el valor mínimo percibido y como FFFFFF el valor máximo. Al solapar las imágenes puede que algún color haya sido digitalizado tomando umbrales distintos. Esto no es problema para la NASA porque ellos tienen la información sobre la normalización de cada toma, pero nosotros, accediendo al repositorio no la tenemos.

Dentro del repositorio de la NASA hay un grupo de imágenes en SOL 8, que parecen ser un test con todos los filtros. Podemos utilizar la mezcla de L2, L5 y L6 y compararla con L4, L5 y L6 para ver las diferencias.

En este caso podemos comprobar que la diferencia no es tan notoria y posiblemente sea una imagen bastante cercana a cómo lo veríamos si nos desplazásemos al planeta rojo.

Como conclusión, decir que la NASA no manipula las imágenes de Marte, sino que simplemente tenemos que saber entenderlas. Esto no es fácil, y por consiguiente estamos en terreno abonado para las teorías conspiratorias que tanto nos gustan.

Referencias:

http://www.goroadachi.com/etemenanki/mars-hiddencolors.htm

http://web.archive.org/web/20040401142127/http://www.atsnn.com/story/30048.html

http://health.howstuffworks.com/human-body/systems/eye/eye3.htm

Moon

10/12/10 03:50

Enorme artículo, LaMentira. ¡Mil felicitaciones!

Líos de filtros aparte , hay cosas con las que discrepo (no del artículo, sino de las publicaciones de la NASA) respecto a las fotografías:

, hay cosas con las que discrepo (no del artículo, sino de las publicaciones de la NASA) respecto a las fotografías:

¿No sería más fácil que ellos las estudiaran en sus tonos rojizos (si son los que mejor les van para apreciar detalles) y que dejaran los filtros naturales para el ojo humano cuando las publicaran en prensa?. Más que nada, por el jaleo de fotos en las que unas se observa Marte rojo, otras amarillo, otras marrón, y con un color de atmósfera cambiante según la foto.

Las imágenes de la bandera estadounidense y las del joystick son muy buen punto de referencia para sintetizar los colores. Creo que la mezcla de los tipos de fotos según sus filtros (algunas exageradamente rojas) crean confusión y mucha conspiración… cuando por ejemplo, se ve reflejado claramente que no tenían ningún problema de realizar una rueda de prensa y que apareciera una imagen no tan roja del planeta no tan rojo.

Saludos cordiales, y enhorabuena otra vez!

Qiong

10/12/10 04:39

Hay una web con un artículo muy completo sobre el color de las fotos de Marte, elaborado por los científicos independientes de Enterprise Mission (en inglés).

Lo cierto es que cuanto más recientes, más se parecen a imágenes de la Tierra en vez del «planeta rojo»:

http://www.enterprisemission.com/colors.htm

Qiong

10/12/10 04:54

«Nada es verdad, nada es mentira, todo depende del cristal con que se mira».

httpv://www.youtube.com/watch?v=8Bq3Zdumgqw&feature=player_embedded

babau

10/12/10 07:27

Venga venga chicos. No seáis desconfiados.

NASA y ESA nos dan lo mejor que tienen y trabajan juntas por el bien de la humanidad.

No esta bien desconfiar así de unas agencias tan buenas que se preocupan por nosotros.

Si el color verdadero es confuso es por nuestro bien y a mayor gloria del avance de la ciencia.

Adoremos todos al gran Hipnosapo

Hoc

11/12/10 08:16

babau dijo:

si, si, como sea, creo que te llaman en Starviewer… :averquepone:

Casette

11/12/10 12:12

A mí toda esta polémica me parece absurda. Las condiciones atmosféricas de Marte no tienen por qué ser las mismas de la Tierra, ni las cámaras fotográficas que envían las mismas que llevamos en los móviles en el bolsillo. Memeces sobre fotografía se llevan oyendo desde las fotos de la Luna, y cualquiera que haya estudiado un mínimo de fotografía sabe que la apertura mínima de objetivo y alta velocidad de exposición necesarias para evitar que la película se achicharre en condiciones extremas de luz hace que otras luces (ej.: ESTRELLAS) desaparezcan o sean casi imperceptibles. Que no necesitará una cámara en Marte

Y si finalmente el cielo marciano es azul… qué? Eso supone que la atmósfera es respirable?

A veces la lógica difusa de la Conspiranoia se me escapa. Salvo que ésta sea partir del punto «NOS MIENTEN!» y construir después cualquier barbaridad con tal de demostrarlo…

Mambru

11/12/10 21:31

Osea, que unas veces las fotos salen asi y otras asao, segun les funcione el filtro de un color u otro para captar mejor los detalles, pero que eso da igual por que luego se normalizan. . No se, recuerdo fotografias bastante mas «rojas» hace algun tiempo, ahora me parecen mas terraqueas, si.

. No se, recuerdo fotografias bastante mas «rojas» hace algun tiempo, ahora me parecen mas terraqueas, si.

Y que al «normalizarse», no siempre salen igual y es solo que hay que saber interpretarlas segun los datos de las señales con que las han captado los filtros.

El photoshop entonces, tiende a normalizar el color segun el valor rgb que mencionas arriba?

Que cosas. Muy currado esto Lamen.

De todas formas, si me parece que cada vez se va viendo menos rojo. Estará perdiendo color como los comics de los kioscos

Saluten!

claudio fm

12/08/12 20:52

jajajajaja

«Como conclusión, decir que la NASA no manipula las imágenes de Marte, sino que simplemente TENEMOS QUE SABER ENTENDERLAS. Esto no es fácil, y por consiguiente estamos en terreno abonado para las teorías conspiratorias que tanto nos gustan.»

ERES UN CRACK MACHO

ademas COPIAS un post de nuevavida11 TAL CUAL y le pones lo que te da la gana

DOBLE CTACK

ademas como en TODA tu WEB SOLO se trata de JUSTIFICAR lo INJUSTIFICABLE, o sea MANIPULAR a la gente patra que no CREa la verdad

estamos en el siglo 21, si la nasa nesesita una foto en X cromatica, la puede hacer SI QUIERE, pero que NO nos TOMe por TONOTS, bueno a TI si, bueno mejor dicho a ti te PAGAN para defender a esta gente y demas!

una foto MANIPULADA, es MANIPULADA, aqui y en pekin, al ELIMINAr colores ELIMINAS DATOS d eInFORMACION muyuyy valiosa, a pero claro la nasa le interesa la informacion? o no?

por eso mandamos al curiosity con camaras en BLANCo y NEGRO y con megalowresolution, cuando en la CALLE tienes camaras 40k si tienes pasta

que tendra la nasa, y nos siguen sacando FOTOs en low resolution y en blanco y negro o en ROJO PINTADO con sus filtros, ES QUE SE ROMPE LA CAMARA SI SACA UNA FOTOS EN coloR normal

A CLARO COMO LAS FOTOS DEL VIKING Y LAS DEL HUBBLEL SE PARECEN TANTO!

ya te e pillado en 3 mentiras, y aludiendoa mentiras para justificar tu mentira tio no cambias, cada vez tiene MENOS credibilidad

roger

6/10/12 22:32

¿No pasaria lo mismo en el fondo marino? la bandera se veria tirando a verdosa por lo tanto el blanco se vería verde y las lineas rojas se verian marrones (eso si el mar fuese verde).

¿Pero al final Marte tiene el cielo azul o no?

Claudio

6/10/12 23:53

mientras más antigua la foto más rojo se ve marte y su atmósfera, eso es porque las cámaras se saturaban.

Ahora, la atmósfera de Marte no es roja, ni tiene porqué serlo.

Sé que para los ignorantes es difícil entender estas cosas, pero la información que manda la sonda viaja una gran distancia, por lo que las imágenes se envían empaquetadas por color, en una sola transmisión continua que no requiere mayor ancho de banda.

CarlosR

6/10/12 23:56

roger dijo:

Si y no. Es algo rojizo durante la mayor parte del día por las partículas de óxido de hierro en suspensión y al atardecer mirando hacia el poniente se ve azulado.

Rodrigo Koi

30/05/14 04:33

Siempre defendiendo lo indefendible? te vas a un monton de vueltas tecnicas para no reconocer una cosa sencilla. Si la NASA quiere presenta las fotos con los colores mas cercanos a la realidad posible. Pero prefiere dar a conocer al publico fotos con colores falsos. El caso de la bandera de EEUU con la capa de color rojo ya es grosero. Me vas a decir que con los millones de dolares que manejan de presupuesto no van a poder mejorar la calidad del color de las fotos?

En tu afán de ser el testaferro de «la verdad» oficial estas quedando mal parado defendiendo lo indefendible.

Amildao

30/05/14 05:48

@ Rodrigo Koi:

¿A quién le hablas?

Si no estás capacitado para darte cuenta que no hay nadie en esta entrada hace más de un año…

Tobaga

30/05/14 11:52

@ Rodrigo Koi:

Es muy fácil criticar sin argumentos, aquí te han dado razones coherentes del por qué, tú no las aceptas, pero en cambio te ves capacitado para criticarlas sin explicación alguna.

Explica tu hipótesis, aver si se aguanta…

Joaquinphi

3/10/15 20:57

Pues me encanta este blog que explica muchas de las modernas mitologias, y especialmente por la sencillez con la que lo hace, no sencillez tecnica sino la de lo obvio.

Pero en este tema creo que perdio todo eso, al final la NASA podria corregir cada problema tecnico ewpecialmente si el objetivo de la mision de miles de millones de dolares es tomar una buena foto que brindr mucha informacion real.

La explicacion casi parece que al hacerla confusamente twcnica se quiere obligar a creerla so pena de no ser tachado dr tonto y que eso.probaria la verdad dr los argumentos.

Me pareceria bueno sin la replantean para hacerla entendible tambien para los tontos como uno…

MaGaO

4/10/15 03:31

Joaquinphi dijo:

O puedes empezar preguntando aquello que no entiendas. Decir explica mejor todo esto sin precisar es hacer perder el tiempo.

Por otro lado, hay cosas que no se pueden explicar con facilidad. Cuentan que Ptolomeo I (a la sazón gobernador de Egipto y fundador de la dinastía de los Ptolomeos) pidió a Euclides de Alejandría un método fácil para aprender geometría y éste respondió: no hay camino real hacia la geometría.

Joaquinphi

4/10/15 09:27

@ MaGaO:

Jajajaja…Ok, tranquilo…

Dr. Bacterio

4/10/15 09:43

@Joaquinphi:

A ver, en astronomía, y Marte por ende, una fotografía en color real ofrece una información muy limitada. Como normalmente una imagen es lo único sobre que trabajar disponible, hay que exprimirla al máximo y sacarle TODA la información, y no solo una poca.

Esto es especialmente util estudiando estrellas, galaxias y nebulosas lejanas. Prácticamente todas las fotografías que ves de Hubble son «montajes». Y tiene que ser así. Pero ese es otro tema.

Volvamos a Marte: la atmósfera y por lo tanto la iluminación aquí son diferentes, ergo la coloración y tonos de los objetos difiere de la que tendrían estando en la Tierra.

En el caso de Marte, ¿quién crees que estudia cada fotografía enviada sobre el terreno? Geólogos, por supuesto. Ellos identifican minerales, rocas, lugares de interés, ayudan a marcar la ruta de Curiosity… Y esto es mucho más fácil hacerlo si las cosas se vieran como en la Tierra, pues los geólogos terrestres están acostumbrado a los colores de los minerales y rocas tal y como se ven aquí. Por eso hay un dial de calibración. Para modificar los colores, si.

Esto no es ningún secreto, pero la caterva de ignorantes que pasan por aquí no tienen ni idea de para que son o se usan filtros, postprocesado de imágenes… Porque nunca en su puñetera y triste vida se interesaron por la astronomía hasta que alguien les dijo que la NASA miente.

Tobaga

4/10/15 12:10

Los filtros de colores para B/N siempre se han utilizado, (y se utilizan), porque son muy útiles para resaltar tonalidades, contrastes, luces, penumbras, brillos, sombras…, o para atenuarlos.

Dejo este artículo que lo explica muy bien, para quien quiera saber mas.

http://www.ejcfotografia.com/filtros-de-color-para-blanco-y-negro-i/

Tobaga

4/10/15 12:41

Espero que este post aclare algunas dudas.

La mayoría de las cámaras que utilizan los astrónomos funcionan en blanco y negro

Las fotos en color son el resultado de mezclar varias imágenes con programas como Photoshop

Una nueva cámara denominada Wide Field Camera 3 (WFC3), instalada en el Hubble en mayo de 2009 sustituyó a la que había montada desde 1995 y que se denominaba Wide Field and Planetary Camera 2 (WFPC2).

La cámara WFC3 utiliza tres sensores diferentes para poder traducir en imágenes la luz que les llega. Éstos se denominan sensores CCD, acrónimo de charge-coupled device (dispositivo de carga acoplada).

Al disponer de tres de estos sensores CCD, la cámara WFC3 del telescopio Hubble puede considerarse realmente como una combinación de dos cámaras en una sola. Así, dos de los sensores funcionan con luz visible y ultravioleta (UVIS), mientras que el tercero es sensible a la luz infrarroja (IR). En el momento de adquirir una imagen, un operador decide a cuál de los dos canales disponibles (ultravioleta-visible o infrarrojo) irá la luz recogida por el espejo del telescopio espacial. Cada uno de ellos proporcionará una información diferente, aunque complementaria, del mismo objeto.

Empezando por los dos sensores que operan con luz visible y ultravioleta, cabe destacar que cada uno de éstos proporciona una resolución de 2048×4096 píxeles. Y, contrariamente a lo que de entrada se podría pensar, funcionan en blanco y negro, y no en color. De hecho, aunque parezca sorprendente, esto no sólo ocurre con la cámara del telescopio Hubble: la inmensa mayoría de las cámaras que utilizan los astrónomos funcionan en blanco y negro. De esta forma se consigue un aprovechamiento más óptimo de los sensores a la vez que se obtienen imágenes con mayor detalle y se pueden registrar con mayor facilidad los objetos más tenues.

Entonces, ¿cómo es posible que Hubble pueda obtener imágenes en color? Una imagen en color puede componerse mediante la mezcla de tres colores primarios: rojo, verde y azul. Combinando rojo, verde y azul en distintas intensidades podemos obtener una enorme gama de colores y, por ejemplo, en la pantalla de cualquier dispositivo electrónico el estado de cada píxel se define mediante la intensidad de estos tres colores individuales. Para poder aplicar este principio y obtener una imagen en color, la cámara WFC3 del Hubble utiliza un conjunto de 63 filtros que se van colocando, según convenga, frente a los sensores UVIS. Cada uno de estos filtros está diseñado para dejar pasar sólo un color determinado, bloqueando al resto.

Si, por ejemplo, se coloca un filtro de color rojo, al sensor sólo llegará la luz de ese color y se obtendrá (en blanco y negro) una imagen del objeto en la que se habrá conseguido aislar este color primario. Si se repite lo mismo con otros dos filtros diferentes para aislar los canales azul y verde, se dispondrá entonces de los tres canales primarios, cada uno de los cuales estará registrado en una imagen en blanco y negro. Al combinar los tres canales, se obtendrá una imagen en color. Esta combinación se hace mediante software. Aunque los astrónomos utilizan programas específicos parallevarla a cabo, aplicaciones de uso general como por ejemplo Photoshop permiten también utilizar esta técnica.

Pero para entender qué es lo que realmente ocurre con las imágenes del Hubble es importante tener en mente que esta combinación se hace con tres imágenes en blanco y negro, a cada una de las cuales les hemos puesto la etiqueta de “rojo”, “verde” y “azul”.

¿Qué ocurriría entonces si una de estas imágenes se obtiene con un filtro de un color diferente al color primario que representa? ¿Y si, por ejemplo, la imagen del canal rojo se obtiene con un filtro violeta? Pues que al combinarlas en nuestro software como si se tratase de rojo, verde y azul, obtendríamos también una imagen en color, si bien el resultado no se correspondería con lo que ve el ojo humano.

La peculiaridad del Hubble es que los canales rojo, verde y azul se obtienen con filtros que no se corresponden realmente con estos colores primarios. Es decir, lo que vemos en las imágenes del Hubble no coincide con lo que veríamos si pudiésemos viajar con una nave espacial hasta las proximidades de la nebulosa y mirarla con nuestros propios ojos. Para obtener el canal rojo se utiliza un filtro denominado S II (leído azufre dos), que sí es de color rojo. Pero para el canal verde se usa un filtro conocido como filtro H-alpha (hidrógeno alfa), que en lugar de ser verde es de un tono de rojo diferente al del filtro S II. Y para obtener el canal azul se utiliza un filtro O III (oxígeno tres), que es de color verde.

El motivo de hacerlo de esta manera, que para alguien ajeno a esta materia puede parecer extraña e ilógica, es que estos tres filtros especiales se corresponden con tres colores básicos (o, dicho en lenguaje técnico, tres longitudes de onda del espectro visible) que tienen una enorme importancia desde el punto de vista astrofísico. Esta reasignación de colores permite aislar colores característicos de la luz que emiten tres de los elementos químicos fundamentales que se encuentran en esta nebulosa y en otros objetos de interés astrofísico (el hidrógeno, el azufre y el oxígeno). Así se aumenta notablemente el nivel de detalle de algunas de las estructuras que aparecen en las imágenes, algo que no se conseguiría si se utilizasen filtros estándar de colores rojo, verde y azul.

A pesar del grado de detalle que muestran las imágenes obtenidas con los sensores UVIS de la cámara WFC3, éstos no nos permiten ver qué hay en el interior de las columnas de gas y polvo cósmico, pues ese polvo bloquea la mayor parte de la luz visible que emiten los objetos que se encuentran dentro de los Pilares. Pero, por suerte, este polvo no es muy eficaz a la hora de bloquear la luz infrarroja. Y es aquí donde el tercer sensor de la cámara WFC3, que tiene una resolución de 1024×1024 píxeles, juega un papel clave. A diferencia de lo que ocurre con el ojo humano, que no puede ver este tipo de luz, el sensor infrarrojo de la WFC3 está específicamente diseñado para detectarla, mostrándonos así imágenes de objetos que de otra forma no podríamos contemplar.

El resultado bruto obtenido por este sensor es también una imagen en blanco y negro. Pero siguiendo el mismo esquema que el utilizado con los sensores UVIS, mediante filtros podemos generar una imagen en color. Para este sensor la cámara WFC3 dispone de 17 filtros diferentes.

En este caso no son filtros de tipo visible, sino filtros que permiten el paso de los infrarrojos. Por decirlo de alguna manera, cada filtro deja pasar a su través una “tonalidad” de infrarrojo diferente. Combinando as imágenes tomadas a través de dos filtros distintos en banda infrarroja es como se obtiene una imagen en falso color con la que podemos interpretar mejor qué es lo que estamos viendo.

La diferencia entre lo que permite mostrar la luz visible y la luz infrarroja queda muy patente en este video producido por la NASA y por la Agencia Espacial Europea. En él se hace una transición suave entre la imagen obtenida con luz visible y la obtenida con luz infrarroja:

https://www.youtube.com/watch?v=8Mne2QwH9oc

De esta manera, gracias a una íntima combinación de ciencia y arte, las técnicas sofisticadas que se esconden tras las imágenes del Hubble nos permiten contemplar toda la belleza que encierran estos objetos, a la vez que nos permiten profundizar cada vez más en la comprensión de nuestro Universo.

Fuente:

Verne (El Pais)

laverdadvergonzosa

8/12/15 21:04

Cuanta parida para intentar justificar que les han pillado jajajaja que ridículos sois los vendidos.

Pruebas, pruebas de tu hipótesis jajajaja se creen que aun están en la universidad donde los reclutaron.

Así que un don nadie con tiempo para aprender a usar el fotochop es capaz de presentar fotos más reales que todos los hinjenieros de la NASA. Es más creíble que prefieren mentir descaradamente pero ¡que les han pillado! (oootra vez)

Tobaga

8/12/15 22:12

@ laverdadvergonzosa:

No eres más tonto porque no te entrenas.

lamentira

8/12/15 22:41

@ Tobaga:

No te creas Toni. Se entrena, y duro.

laverdadvergonzosa

8/12/15 22:52

Compruebo que la calidad de sus argumentos van in crescendo.

Tobaga

8/12/15 23:23

doc halliday dijo:

Gracias. Lo hice con la intención de aclarar de una vez todas las dudas, creía que después no vendría nadie más diciendo chorradas.